Читайте также

-

Монетарная политика ФРС, цены на электронику, спад в сегменте AR/VR: все, что волновало российский ИТ-рынок в начале весны. Аналитика IT News

19.04.2024 10:51:37 | it-world

Ритейлеры пожаловались на покупателей, которые намеренно портят технику и взыскивают компенсации через суд

19.04.2024 10:19:57 | vc.ru

Ритейлеры пожаловались на покупателей, которые намеренно портят технику и взыскивают компенсации через суд

19.04.2024 10:19:57 | vc.ru

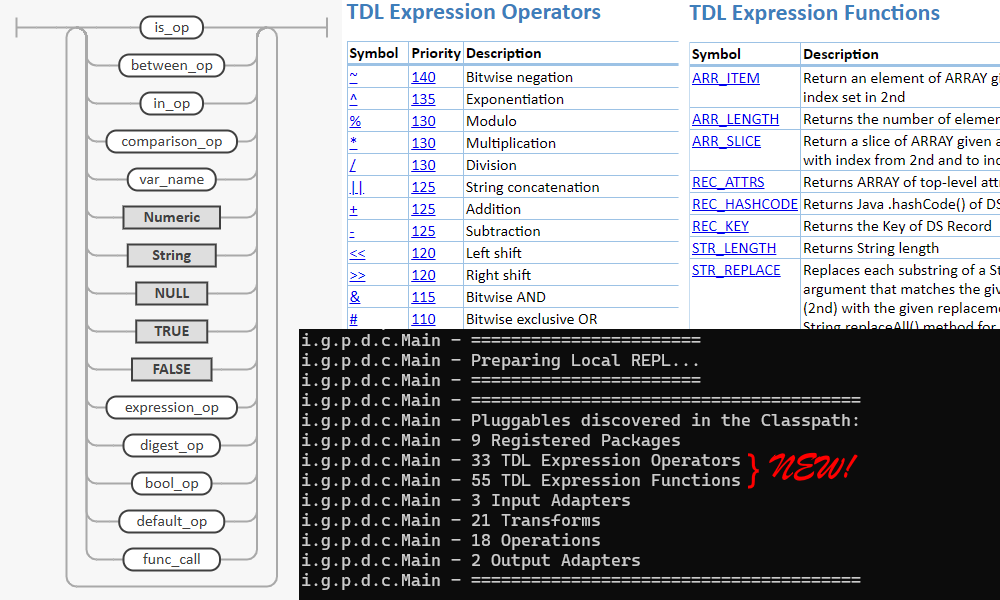

Просто ли открывается ларчик, Или как протестировать сразу более 10 сервисов

19.04.2024 10:04:33 | Хабр

«МТС Банк» объявил ценовой диапазон IPO — от 2350 рублей до 2500 рублей за акцию

19.04.2024 09:47:12 | vc.ru

Компания в сфере ИИ предложила создавать цифровых клонов людей для различных нужд

19.04.2024 09:45:00 | ferra.ru

Как общаться с базой знаний на естественном языке с помощью LLM и объективно оценить работу полученной системы

19.04.2024 09:21:05 | Хабр

МИД предложил открыть для россиян точки оформления электронных подписей в Кыргызстане, Казахстане, Армении и Узбекистане

19.04.2024 09:13:07 | vc.ru

Проекции в Vertica: что это, как использовать, и почему не стоит создавать их под каждый запрос

19.04.2024 09:09:16 | Хабр

Марсианский вертолёт и после обрыва связи продолжит отправлять NASA данные

19.04.2024 09:00:00 | ferra.ru

Как я проходила стажировку в отделе аналитических решений почти без опыта работы с данными

19.04.2024 08:26:12 | Хабр

Неудачный ремонт ноутбука Acer V3-572: диагностируем неисправность с помощью тока и тепловизора

19.04.2024 08:21:04 | Хабр

Чип Samsung Exynos 2500 окажется энергоэффективнее новейшего Snapdragon 8 Gen 4

19.04.2024 08:18:23 | ferra.ru

Предсказано большее потребление энергии дата-центрами, чем всей Индией к 2030 году

19.04.2024 08:15:00 | ferra.ru

День 786: средняя стоимость перелёта по России в экономклассе в первом квартале 2024 года выросла на 25%

19.04.2024 08:14:39 | vc.ru

Дизайн и характеристики OnePlus Ace 3 Pro слили в сеть накануне анонса

19.04.2024 08:09:22 | ferra.ru

НОВОСТИ

-

Невинная тяга к сладкому может говорить о страшной болезни, предупредила врач

02.05.2024 20:36:20 | Life.ru

Андрей Ведищев: «Очень хотим взять реванш у УНИКСа за прошлогодний финал»

02.05.2024 20:36:00 | Sports.ru

Двоеглазова: «Психологически готова к переходу во взрослое катание»

02.05.2024 20:35:00 | Спорт-Экспресс

Мяч попал Мойзесу в плечо в штрафной ЦСКА. Карасев после ВАР решил не назначать пенальти и не удалять бразильца

02.05.2024 20:34:00 | Sports.ru

Защитник «Локомотива» Митай назвал причину проблем команды при игре в обороне

02.05.2024 20:33:00 | Спорт-Экспресс

Дитц заработает 65 млн рублей в «Авангарде» в следующем сезоне (Metaratings)

02.05.2024 20:33:00 | Sports.ru

В НАТО обвинили Россию в «гибридной вредоносной деятельности» на территории блока

02.05.2024 20:31:53 | Известия

Елена Вайцеховская: «Ефимова – спортсменка с американским менталитетом. У Вяльбе хватает мужества называть вещи своими именами»

02.05.2024 20:30:00 | Sports.ru

На американца Гилмана, осуждённого в Воронеже, завели новое уголовное дело

02.05.2024 20:27:22 | Life.ru

Разведка США считает, что удар по посольству Ирана в Дамаске нанес Израиль

02.05.2024 20:27:18 | ТАСС

Источник: «Пари НН» не может договориться с «Атромитосом» о сумме компенсации за тренера Илича

02.05.2024 20:27:00 | Спорт-Экспресс

МИД РФ заявил о намерении добиваться наказания причастных к трагедии 2 мая в Одессе

02.05.2024 20:26:30 | Известия

Романцев о ВАР: «Думал, станет больше порядка, меньше споров и скандалов, но все наоборот»

02.05.2024 20:25:00 | Sports.ru

Эксперт Колин Каухерд: «Пол Джордж сказал: «Это не то, кем мы являемся». К сожалению, это именно то, кем вы являетесь»

02.05.2024 20:25:00 | Sports.ru

«Зенит» нанес 1 удар за тайм с ЦСКА – мимо ворот. Армейцы пробили 4 раза

02.05.2024 20:25:00 | Sports.ru

Рада хочет запретить публиковать в судебном реестре решения о мобилизации и военном учете

02.05.2024 20:24:11 | ТАСС

На востоке ДРК повстанческая группировка М23 захватила несколько населенных пунктов

02.05.2024 20:22:09 | ТАСС

Лавров: РФ готова содействовать возобновлению переговоров между общинами Кипра

02.05.2024 20:21:07 | ТАСС

На двух участках трассы "Иртыш" ограничили движение грузовиков из-за паводков

02.05.2024 20:20:42 | ТАСС

Замглавы МИД РФ обсудил с послом ОАЭ ситуацию в зоне палестино-израильского конфликта

02.05.2024 20:19:41 | ТАСС

Посольство РФ заявило о лицемерном игнорировании США репрессий Киева против УПЦ

02.05.2024 20:18:51 | Известия

Свентек обошла Серену Уильямс по проценту выходов в финал турниров серии WTA 1000

02.05.2024 20:18:00 | Спорт-Экспресс

ПИШИТЕ

Техническая поддержка проекта ВсеТут