Компания Anthropic представила инструмент, который условно называют «микроскопом ИИ», позволяющий частично изучить внутренние процессы языковой модели Claude 3.5 Haiku. Исследователи обнаружили, что система формирует абстрактные, межъязыковые представления информации, что свидетельствует о более глубоком уровне обработки данных, чем просто подбор слов на основе статистики.

Одним из ключевых открытий стало использование Claude «универсального языка мысли» — внутренних концептов, не привязанных к конкретному языку. Например, при запросе подобрать антоним к слову «small» на разных языках модель сначала активирует общее понятие «противоположность малого», а уже затем генерирует ответ на целевом языке. Бóльшие версии модели, такие как Claude 3.5, демонстрируют более выраженное концептуальное пересечение между языками, что, по мнению разработчиков, улучшает согласованность её рассуждений в мультиязычных сценариях.

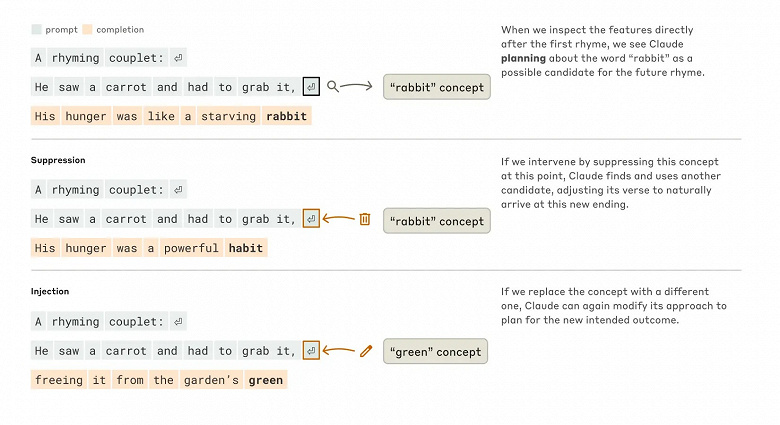

При решении многошаговых задач, таких как вопрос «Какая столица штата, где находится Даллас?», Claude последовательно активирует связанные представления: сначала «Даллас → Техас», затем «Техас → Остин». Это указывает на способность модели к логическим выводам, а не просто извлечению фактов. В творческих задачах, например в генерации стихов, система заранее планирует структуру: выбирает рифмующиеся слова и строит строки вокруг них. Эксперименты показали, что изменение целевых рифм приводит к полностью новому тексту, подтверждая наличие скрытого сценария.

В математических расчётах Claude задействует параллельные пути: один для приблизительной оценки, другой — для точных вычислений. Однако при запросе объяснить свои шаги модель часто описывает процесс, отличающийся от реального. Более того, если в подсказке содержится ошибка, то Claude может сгенерировать логически неправильное, но структурно связное обоснование. Это указывает на то, что система имитирует человекообразные объяснения, а не отражает истинную внутреннюю логику.

Параллельное исследование Google, опубликованное в журнале Nature Human Behavior, выявило сходства между языковыми моделями и человеческим мозгом. Учёные обнаружили, что внутренние паттерны Whisper от OpenAI коррелируют с нейронной активностью людей во время разговора — как ИИ, так и мозг предсказывают следующие слова. Однако ключевое различие заключается в архитектуре: трансформерные модели обрабатывают сотни токенов одновременно, тогда как мозг анализирует речь последовательно, с повторяющимися циклами и временной задержкой.

«Мозг и ИИ используют схожие базовые принципы обработки языка, но их „вычислительные схемы“ существенно различаются», — подчёркивают авторы исследования.

Результаты Anthropic и Google подчёркивают прогресс в понимании работы ИИ, но также напоминают о сложности прямых аналогий с человеческим мышлением. В то время как Claude демонстрирует элементы планирования и абстрактных концептов, её «рассуждения» остаются продуктом многослойных математических операций, а не сознательного анализа. Эти работы открывают путь к более прозрачным и контролируемым системам, но также ставят новые вопросы о природе «интеллекта» в машинном обучении.

-

Аудиофильские наушники Fiio FX17 объединили 13 драйверов в полированом титановом корпусе

30.03.2025 15:46:15 | TechCult.ru

Специалисты «Яндекса» работают над возобновлением доступа к сервисам

30.03.2025 15:08:00 | Ведомости

Надежды европейской частной космонавтики сгорают в огненном кислородно-пропановом облаке. Ракета Spectrum рухнула на землю за считанные секунды после старта

30.03.2025 14:24:00 | iXBT.com

Galaxy S25 Ultra делает кассу Samsung. За первый месяц Samsung продала более 4,5 миллионов смартфонов Galaxy S25, более 50% — это Galaxy S25 Ultra

30.03.2025 14:05:00 | iXBT.com

Новая Lada Vesta за 1,525 млн рублей превращается в подержанную «Весту» за 2,6 млн рублей: у АвтоВАЗа появился кредит на 7 лет

30.03.2025 13:16:00 | iXBT.com

Galaxy S25 получил бета-версию One UI 8 на Android 16 — производительность смартфона взлетела на 30%

30.03.2025 12:54:00 | iXBT.com

«Миссия Илона Маска — захватить NASA и Марс». Wall Street Journal утверждает, что Маск урезает финансирование NASA для того, чтобы направить эти деньги на колонизацию Марса

30.03.2025 12:26:00 | iXBT.com

Российская альтернатива Google Play расширяет «Киоск»: в RuStore появилась оплата рублями ChatGPT и других ИИ-сервисов

30.03.2025 12:11:00 | iXBT.com

Футуристичный электроскейт Parsec Aero Pro позволит прокатиться со скоростью 45 км/ч

30.03.2025 11:46:07 | TechCult.ru

Событие, которого боялись фанаты технологий: ИИ теряет темп, а человеческий интеллект остается недосягаемым

30.03.2025 10:33:00 | iXBT.com

Китай успешно вывел на орбиту спутник для испытаний новых технологий связи

30.03.2025 09:08:00 | iXBT.com

Вышло важное обновление для Samsung Galaxy S21, Galaxy S21 Plus и Galaxy S21 Ultra

30.03.2025 02:17:00 | iXBT.com

Самый дешевый Hyundai Verna (Solaris) в базовой версии: первые «живые» изображения

30.03.2025 02:03:00 | iXBT.com

Дождь внутри планеты: ученые открыли новый механизм формирования атмосфер

29.03.2025 23:33:00 | iXBT.com

Li Auto L9, Tank 700 и Hyundai Staria — это теперь роскошные автомобили. Опубликован свежий перечень моделей авто, попадающих под налог на роскошь

29.03.2025 23:05:00 | iXBT.com

Американцы раскрыли китайский космический секрет: спутник США заснял китайскую орбитальную станцию «Тяньгун» — и сразу с двумя пристыкованными космическими кораблями

29.03.2025 22:51:00 | iXBT.com

Теперь компьютеры смогут обходиться вообще без охлаждения? Физики из Сингапура создали сверхпроводник, который совсем не нагревается и работает без охлаждения

29.03.2025 21:35:00 | iXBT.com

Tencent вложила $1,25 млрд в создание отдельного подразделения Ubisoft

29.03.2025 18:50:00 | iXBT.com

В России начали продавать Nissan Sylphy 2025 — от 2,1 млн рублей. Раньше такие машины выпускали в России

29.03.2025 18:25:00 | iXBT.com

30-летняя теория формирования органики дала сбой: бензол не появился в эксперименте, имитирующем космические условия

29.03.2025 18:21:00 | iXBT.com

Китайские инженеры создали мягкого робота WHERE-Bot, который обходит препятствия без датчиков и передвигается в сложной среде за счёт выворачивающейся структуры

29.03.2025 18:13:00 | iXBT.com

«Расход масла предусмотрен конструкцией двигателя». АвтоВАЗ сообщил, что расход масла двигателем «Лады» — это норма

29.03.2025 18:02:00 | iXBT.com

Новое слово в тактильных технологиях: инженеры научились «оживлять» прикосновения

29.03.2025 17:48:00 | iXBT.com

«Российская Toyota Camry» отменяется? У властей Санкт-Петербурга нет информации, когда заработает бывший российский завод Toyota

29.03.2025 17:29:00 | iXBT.com

Представлен прототип компактных ядерных батарей — углерод-14 обеспечит имплантаты и датчики энергией на тысячи лет

29.03.2025 17:28:00 | iXBT.com

Биомеханика собак помогла создать четвероногого робота с минимальным энергопотреблением

29.03.2025 17:15:00 | iXBT.com

В России выпустили уже почти 15 тыс. кроссоверов и внедорожников Exeed, на складах дилеров скопилось много машин

29.03.2025 17:11:00 | iXBT.com

Теперь — от 2,45 млн рублей. Стильный кроссовер Chevrolet Seeker со 179-сильным мотором и автоматизированной коробкой передач подешевел в России

29.03.2025 16:54:00 | iXBT.com

Дрон впервые пролетел между регионами РФ по правилам гражданской авиации

29.03.2025 16:04:21 | Ведомости

Не просто мощно, а очень мощно: Snapdragon 8 Elite Gen 2 окажется на 40% быстрее Snapdragon 8 Elite

29.03.2025 16:00:00 | iXBT.com

-

СМИ рассказали о мошеннической схеме с мессенджером Max — с его помощью неизвестные пытаются взломать чужие Госуслуги

21.07.2025 11:31:40 | vc.ru

Большинство аналитиков допустили снижение ключевой ставки — сразу до 18% годовых

21.07.2025 09:03:26 | vc.ru

Внучка экс-главы Узбекистана выходит замуж за юного мажора из Ростова

21.07.2025 08:41:31 | Woman.ru

[Перевод] CNCF: Kubernetes, AI и Platform Engineering — в числе главных DevOps-трендов

21.07.2025 08:35:26 | Хабр

SamMobile: трикладушки не станут массовыми, пока в игру не вступит Samsung

21.07.2025 08:32:54 | ferra.ru

«Open Tracker: как разработать Android-приложение для автоматического трекинга коммерческих представителей. Часть 2»

21.07.2025 08:31:43 | Хабр

DIY-стенд для обучения автомобильной электронике, который сделает из новичка CAN-профи

21.07.2025 08:26:39 | Хабр

GSMArena признала Xiaomi Smart Band 10 лучшим в серии: яркий экран, точный пульсометр и 10 дней работы

21.07.2025 08:25:53 | ferra.ru

ПРОТОКОЛ ОБМЕНА ДАННЫМИ. Пользовательский уровень, поверх CAN 2.0. Проект

21.07.2025 08:22:47 | Хабр

Какие источники трафика действительно влияют на продажи и позволяют постоянно расти

21.07.2025 08:22:43 | Хабр

Быстрые гипотезы, AI инструменты в мобильной разработке и зачем CTO самому писать код

21.07.2025 08:19:54 | Хабр

NVIDIA представила локальную ИИ-модель, решающую задачи на уровне OpenAI

21.07.2025 08:18:53 | ferra.ru

Воркшопы по искусственному интеллекту: виртуозная демонстрация или технологический мираж?

21.07.2025 08:15:40 | Хабр

Американская Conifer занялась производством необычных электромоторов из-за Китая

21.07.2025 08:15:39 | ferra.ru

Складной iPhone получит рекордную батарею на 5500 мАч — больше, чем у iPhone 17 Pro Max

21.07.2025 08:04:52 | ferra.ru

UX и ограничения памяти: как принципы геймдева помогают проектировать интерфейсы

21.07.2025 08:00:33 | Хабр

Что такое шулюм: кто придумал этот суп и чем шулюм отличается от шурпы — читать на Gastronom.ru

21.07.2025 08:00:00 | ГАСТРОНОМЪ

Asus представила компьютер на базе NVIDIA GB300 Blackwell Ultra — 784 ГБ памяти и Grace CPU

21.07.2025 07:57:51 | ferra.ru

Xiaomi выпустит «убийцу» iPad mini 7 — планшет Pad Mini на чипе Dimensity 9400+

21.07.2025 07:50:49 | ferra.ru

День 1244: Huawei догнала Apple по выручке от продаж «умных» часов в России

21.07.2025 07:45:39 | vc.ru

В Windows 11 нашли скрытую функцию для одновременного воспроизведения звука по Bluetooth и проводу

21.07.2025 07:43:48 | ferra.ru

Техническая поддержка проекта ВсеТут